DeepSeek-R1本地+API最强部署,8b+70b+671b满血版!联网搜索+公网访问+思考推理+全终端可用!Ollama+OpenWebUI

- 2025-02-22 20:26:00

- admin 原创

- 1048

DeepSeek-R1本地+API最强部署,8b+70b+671b满血版!联网搜索+公网访问+思考推理+全终端可用!Ollama+OpenWebUI

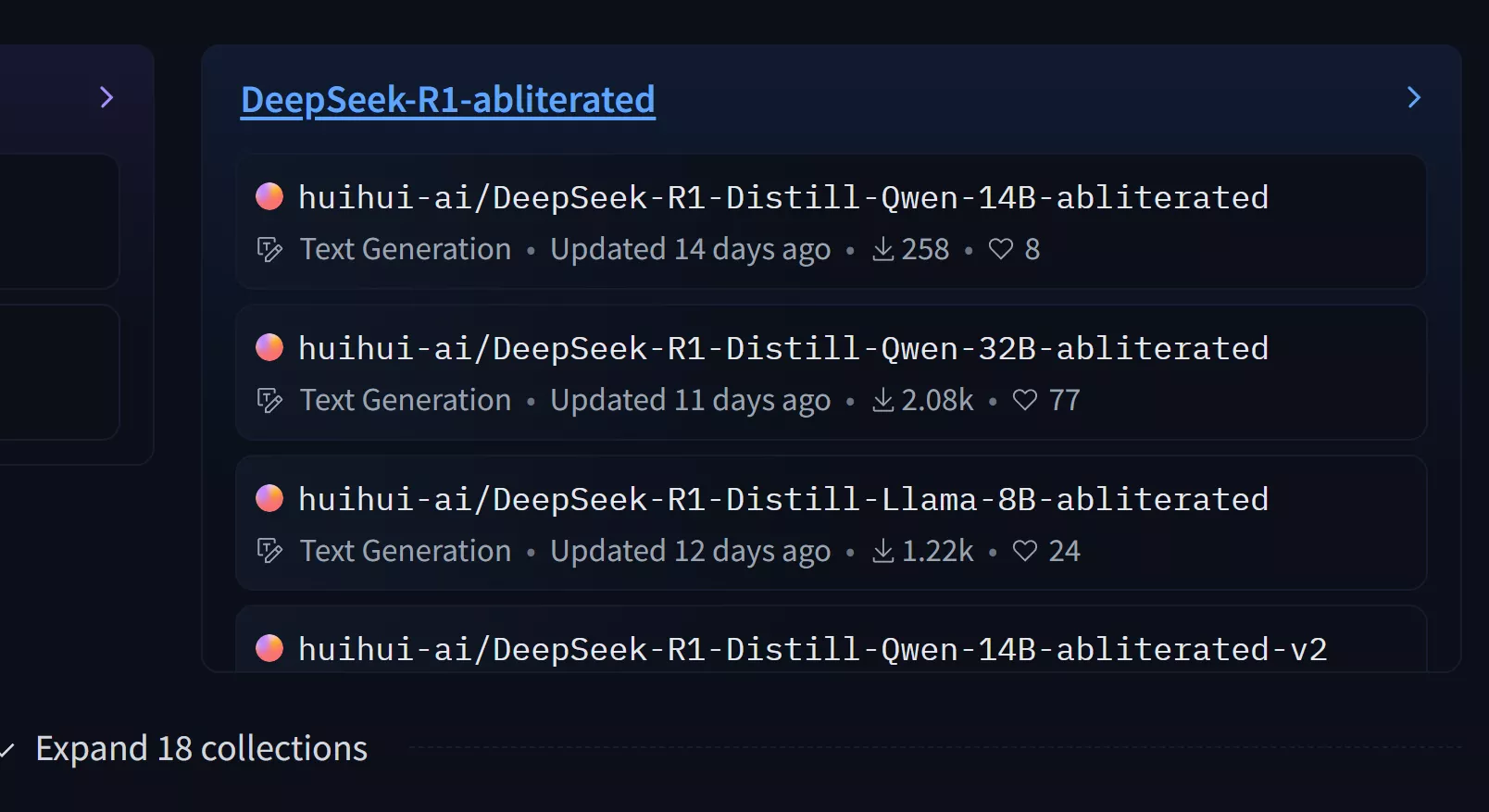

越狱版的DeepSeek R1现已托管在Hugging face上,支持8B、14B、32B 【 链接直达】

可能有人会觉得越狱版没有官方版聪明,这是一个比较大的误解,官方版可是671B的,普通人是跑不起来的,大多数人能本地运行的都是7b、8b、14b、32b这几大类型的模型,是被蒸馏压缩过的,无法直接和671B相比,但是自己本地使用已足够。

本地部署越狱版步骤

1、下载并安装Ollama 【 点击下载】

2、在CMD终端下通过命令下载DeepSeek R1越狱版

7b

ollama run huihui_ai/deepseek-r1-abliterated:7b

8b

ollama run huihui_ai/deepseek-r1-abliterated:8b

14b

ollama run huihui_ai/deepseek-r1-abliterated:14b

32b

ollama run huihui_ai/deepseek-r1-abliterated:32b

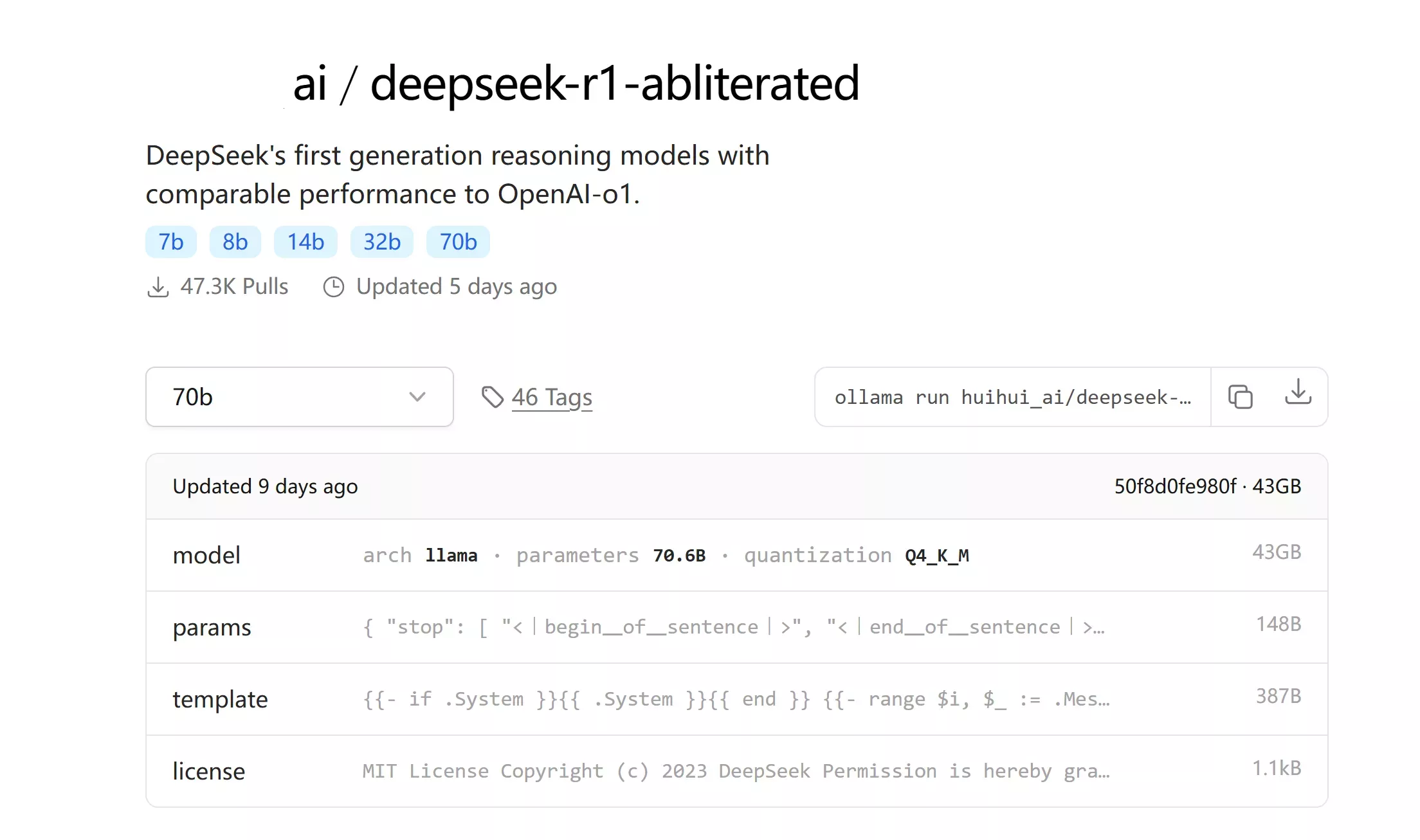

70b

ollama run huihui_ai/deepseek-r1-abliterated:70b

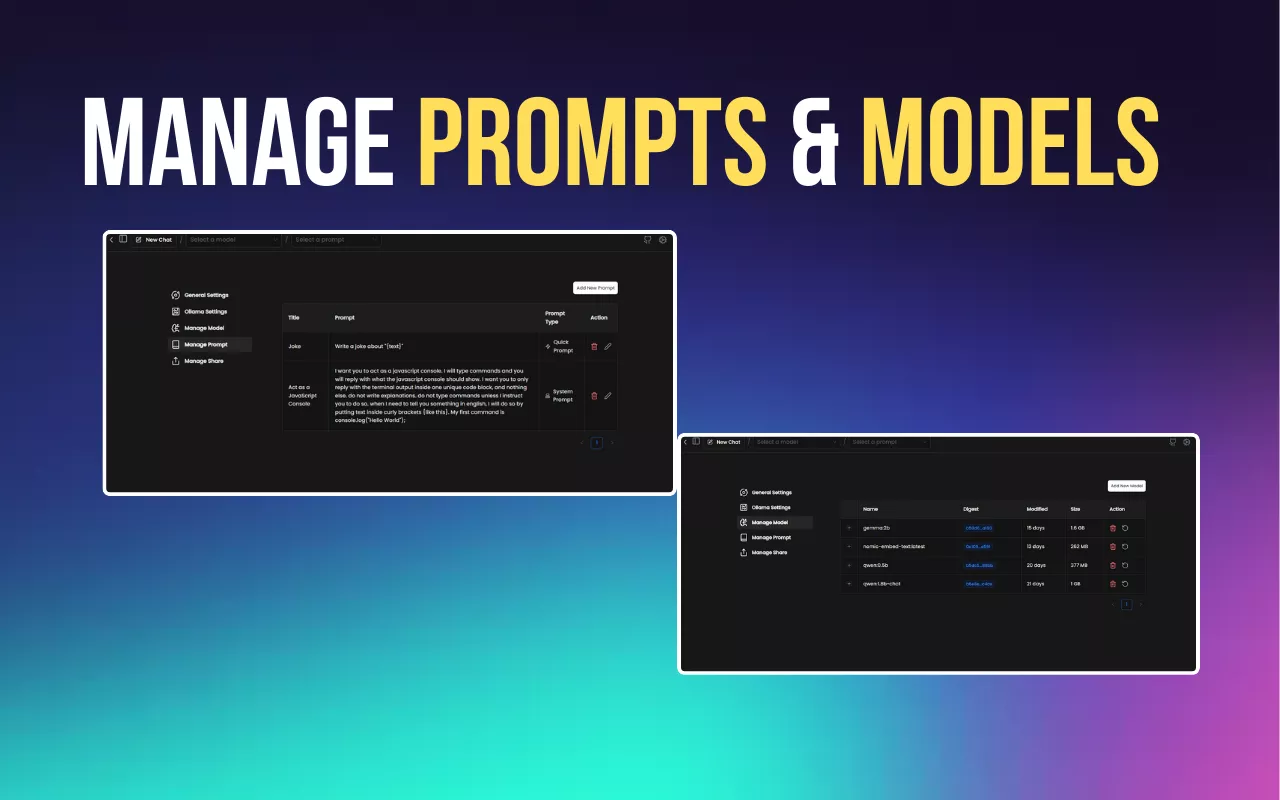

3、安装 Web UI

这里有2中web ui

3.1

Page Assist - 本地 AI 模型的 Web UI

就可以本地调用 deepseek r1 越狱版 AI 大模型

3.2 open webui

安装open-webui服务

pip install open-webui

启动open-webui服务

open-webui serve

最后

如需卸载删除已安装的模型,可以通过下面命令执行:

ollama rm < 模型名称 >

| 联系人: | 透明七彩巨人 |

|---|---|

| Email: | weok168@gmail.com |